در دهه های اخیر، یکی از مهمترین موضوعها که همواره جنجال زیادی بر سر آن مطرح بوده و حتی تبدیل به سوژه فیلم ها و رمان ها هم شده است، قضیه هوش مصنوعی است. مانند هر فناوری جدید دیگر، بحث از خطرها و جنبه های تاریک، هوش مصنوعی هم همواره توجه ها را به خود جلب کرده است؛ از جمله در آخرین نشست «انجمن امریکایی برای پیشرفت علم» (AAAS) که در آن دانشمندان علم کامپیوتر و اخلاق را به دور هم جمع کرد.

در دهه های اخیر، یکی از مهمترین موضوعها که همواره جنجال زیادی بر سر آن مطرح بوده و حتی تبدیل به سوژه فیلم ها و رمان ها هم شده است، قضیه هوش مصنوعی است. مانند هر فناوری جدید دیگر، بحث از خطرها و جنبه های تاریک، هوش مصنوعی هم همواره توجه ها را به خود جلب کرده است؛ از جمله در آخرین نشست «انجمن امریکایی برای پیشرفت علم» (AAAS) که در آن دانشمندان علم کامپیوتر و اخلاق را به دور هم جمع کرد.

به عنوان مثال، شکی در تأثیر ربات ها در اقتصاد امروز ما نیست. آن ها بازدهی و دقت را به شدت بالا میبرند؛ اما نباید روی دیگر این سکه را نادیده گرفت. این روبوت ها هم چنین ارتباط میان توسعه و رونق اقتصادی با اشتغال را هم تضعیف کردهاند. دیگر مانند زمان گذشته با رونق اقتصادی، این وضعیت میان افراد جویای کار به خوبی حس نمیشود. این نکتهای است که «موشه واردی» (Moshe Vardi) به آن اشاره میکند.

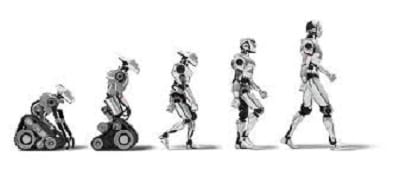

به گفته این استاد مهندسی محاسبات دانشگاه، این فناوری اشتغال را نابود کرده است. شما تنها لازم است تا یک روبوت بخرید تا مثل یک اسب باری تمام وقت برای شما کار کند و بر خلاف گذشته به نظارت انسانی هم نیاز نداشته باشد. در حقیقت، روبوت ها به سمتی پیش میروند که تقریباً هر چیزی را بهتر از انسانها انجام میدهند. به نظر او، با افزایش نفوذ روبوتها این احتمال هست که اتفاقی که برای اقتصاد روم باستان به دلیل وابسته بودن به بردهها افتاد، برای ما هم به دلیل وابسته بودن به روبوتها بیفتد.

به گفته یکی دیگر از حاضران در این نشست، «وندال والاش» (Wendell Wallach) استاد اخلاق دانشگاه ییل، یک موضوع مهم در مورد روبوتها، پیامدهای اخلاقی آن است. به نظر او، شرکتها باید بخشی از بودجه پژوهشی خود را صرف تحقیق در مورد دلالتهای اخلاقی، قانونی و پیامدهای اجتماعی (ELSI) این فناوری کنند؛ مانند آن چه در زمینه علم ژنتیک صورت پذیرفته است و بنا بر قانون فدرال امریکا، شرکتهای مربوطه موظف هستند، 5 درصد از بودجه خود را در حوزۀ ELSI هزینه کنند.

به اعتقاد والاش، ما بایستی به یک مجموعه راه حل منسجم و هماهنگ در این مورد برسیم تا مانع از این شویم که فناوریهای پیش روی خود به یک خطر عمده تبدیل شوند. قضیه خودرانها مثال خوبی را در مورد این مشکل فراهم میکند. در مورد این قضیه، یک پرسش جدی توسط «کوبایاشی مارو» (Kobayashi Maru) مطرح شده و به قضیه «مشکل گاری بارکش» (Trolley Problem) مشهور است؛ بنابراین، خودرانها یک مشکل عمده در برابر دو برونداد نامناسب همزمان هستند؛ مثلا انتخاب میان برخورد با یک گروه کودک در خیابان و نجات سرنشینان و یا کوبیدن به یک درخت و نجات و کودکان و فدا کردن سرنشینان.

در هر حال، به نظر والاش، این مسأله ای کمیاب است و هیچ راه حل اخلاقی سرراستی برای آن وجود ندارد. با وجود این، این مشکل وجود دارد و به گفته متخصصان خودروساز، هدایت هوشمند هنوز یک فناوری جدید است و نمیتواند میان یک اتوبوس مدرسه بچهها و یک تراکتور تفاوتی قائل شود و همه آنها را به عنوان «مانع» به شمار میآورد.

بنابراین، نظر والاش این یک ضرورت است که پژوهشگران و تئوریسینهای علوم اجتماعی هم در برنامه های هوش مصنوعی جای داده شوند و به همراه مهندسان، این قضیه را مورد ملاحظه قرار دهند که اگر اشکالی در سیستمهای طراحی شده آنها پدید بیاید چه اتفاقی میافتد.

یک مشکل مهم دیگر که والاش به آن اشاره و تأکید دارد، در مورد واگذاری اختیار به دستگاههای ساخت بشر برای کشتن آدمهاست. این دغدغه بسیار مهم که در مورد استفاده از رباتهای هوشمند در جنگها و واگذاریِ اختیار انتخاب اهداف به خود آنها مطرح شده، یک بحث کلیدی است. در حقیقت، بر خلاف مشکلی که در خودرانها وجود دارد، در اینجا مشکل اصلی تواناییِ انتخاب است و نه عدم توانایی آن. به اعتقاد والاش، روبوتها به طور کامل قابل کنترل نبوده و پیشبینی ناپذیرند. هم چنین، بار کردن مسئولت بر آنها اگر نه غیرممکن، بسیار دشوار است، چون کارگزاران انسانی حداقلی از اخلاقیت و مسئولیت انسانی دارند. روبوتها این اصول اخلاقی را تضعیف میکنند و ورود آنها به یک صحنه کشتار مانند جنگ پیامدهای فوقالعاده خطرناکی به بار میآورد.

tabnak.ir

امتیاز به این نوشته